DX時代のコンサートホール:音響AI解析 [コンサートホール&オペラハウス]

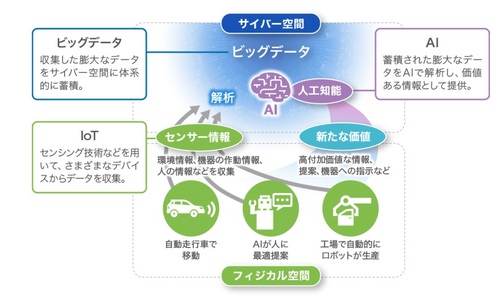

これからのDX時代のツールとして、やはりAIは使っていかないといけないだろう。AIは次世代の社会を支える、とても重要な技術である。人工知能(AI)とは、人間の知的活動をコンピュータを使って人工的に再現したものであり、次世代の社会を支える主要技術のひとつ。

プログラミングとデータ解析を組み合わせて新しい価値を創造する、とても重要なクリエイティブツールなのだ。

●AIにできること

AIには、できること(得意なこと)とできないこと(苦手なこと)がある。得意なことは、大量のデータ処理、ルールに沿った作業、共通点を見つける作業などである。

音声認識・応答

文章認識

画像認識

推論

機械制御

いまAIを使っていろいろな凄いことができてしまうのは驚きだが、自分はそのようなAIを使ってどういう機能を作るというよりは、なぜそんな凄いことができてしまうのか、AIそのものの構造に興味がある。まずそこを理解したいと昔から思っている。

まっおそらくAIのアルゴリズムとして、ニューラルネットワークとか機械学習、デープラーニングというアルゴリズムがあって、人間の脳の構造、思考回路をそのままコンピュータ上で実現する、そんなイメージである。で、実際おこなう処理は、いわゆる総当たり計算に近い、すべてのパターンを計算してしまう膨大な計算量で、AI将棋とかAI囲碁、AIチェスなんかもそうですね。愚手からなにからすべて総当たりの手を計算して全部選び出し、そこから最善手を計算する。AIとはそういう計算の仕方をするのである。

だから膨大な計算量が必要になり、昔はスーパーコンピューターでないと処理できないものであったが、昨今のPCのCPUの著しいハイパフォーマンス向上で、家庭用PCあるいはワークステーションでも充分AIを動かすことができるようになった、ということだろう。

AIはまずアルゴリズムがあって、そのアルゴリズムのおかげで、信じられないレベルのことが実現できてしまう,それだけの膨大な演算が可能になった、というのがAIの正体なのだと思う。そしてそれを実現するためにハードウエアが後から追いついてきた、ということなのだろう。

それで、AIを使って実際凄い機能を実現するフェーズになると、おそらくOSのAPIみたいなプログラミングライブラリがあって、通常ソフトエンジニアはそのAPIを使ってアプリケーションを開発する。

それはAIのニューラルネットワーク、機械学習、ディープラーニングのアルゴリズムを利用するために欲しい機能をプログラム開発するためのAPI相当のライブラリがあるに違いない。そういうものがあるのだろう。そういうAPIを使ってプログラミングしていて、欲しい機能を実現しているのであろう。

全部私の推測レベルです。古い時代の技術者のたとえですみません(笑)

tackさんから教えてもらったところ多いです。(笑)

見当はずれのところもあるかもだが、まぁまぁ。。。

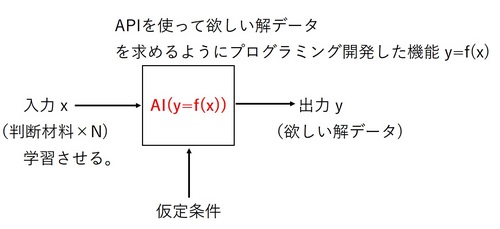

AIのシステム図みたいなものを作るとしたら、こんなイメージであろう。

入力xのデータとして、まずAIに学習させるデータは、判断材料である。ある結果を導き出したいためにそれをおこなうためには、まずその判断材料をAIに学習させる必要がある。それは複数N個あっていい。(AIはそれこそ膨大な学習能力・処理計算ができる。)

AIは、プログラミングライブラリAPIを使ってソフトエンジニアが開発した欲しい機能(解)を出力するための機能関数みたいなものである。y=f(x)

出力させる前に、どういう条件下でという仮定条件を入力する。

その仮定条件に応じた形での解を出力する。それが出力yである。

つまり膨大な学習データを徹底的に解析して、その特徴を整理できる能力があり、その解析データに基づいて、その入力の仮定条件に適した解を導き出して出力するのである。

AIの機能ってこんなイメージなのかなと自分は勝手に想像している。あくまでAI機能を実現するイメージ図である。

最近のAIの開発で驚いているのが”ChatGPT”である。

ついにここまで来たか!という感じである。

いつかChatGPTを自分でも試してみて、これひとつのテーマで日記を書いてみたいと思っている。

まだ自分もよく理解していないところもあるが、ある質問、テーマを投げかければ、そのまま文章を書いてしまうAIである。いろいろなAIの機能が出てもあまり驚かない自分ではあるが、このChatGPTはちょっと恐怖に感じてしまった。

文章、文体と言うのはある意味、人間の個性である。

その人の考え方、性格が、その個性を生み出している要因である。

その人々によってそれぞれの個性の文体が存在する。

でも判断材料として、その人の文章を大量に学習させれば、ある仮定条件、質問を投げかければ、新たに書くテーマもその人の文章になってしまうのか?

これは恐怖である。(笑)

自分の文体、考え方が、そのままAIで書けてしまうのか?

ChatGPTは、まだ出たばかりのAIだから、そこまでの精度はないと思うが、それも時間の問題だろう。

自分も含めて、文筆業の方々にとっては恐怖である。

ある小説家、作家が亡くなっても、続編の小説が読めるのである。(笑)

自分が最近興味があるのが、AIが創作したものに著作権があるか、というテーマである。その文献を見かけたことがあり、そのままお気に入りに保持しているので、後日読んで感想を書いてみたいと思う。

MicrosoftがChatGPTのオープンAIに複数年で100億ドル投資したニュース記事を読んだ。どんどん精度が上がっていくに違いない。

さて、話がそれてしまったが、AIの活躍する分野というのは、やはり信号処理(画像・音声)と解析・予測である。

コンサートホールといえば、自分はもう音響、ホール音響、ホールの響きである。この天がお召あそばされた深遠なる建築音響の世界。まさに数学理論の世界。建築音響の専門書を読んでも数式だらけでチンプンカンプンである。(笑)

でもコンサートホールが好きで好きで堪らないホール愛好家の自分は、この深遠なるホール音響の世界をなんとか素人の人にもわかりやすいようなイメージで説明できないか、をチャレンジしたことがあった。それが2017年に連載した「コンサートホールの音響のしくみと評価」の連載日記である。これで、普段コンサートホールのステージ上で奏者が奏でる音が、ホール内をどのように伝搬し、反射し我々聴衆の耳に届くのかを理解できた。ホール音響の世界は、神秘的でミステリアスである。

ホールの容積、形状、天井の高さ、壁、天井、床の材質、それぞれに凹凸をつけたりの工夫、反響板、座席に使うシートの吸音性、ステージ床の材質、ステージ床下の空洞、もうすべてにおいてホール音響の要因作りの一因である。

音の印象の違いを決めるのが反射音のバランス。

ステージ上の楽器からの音が直接届いた直後の0.1秒間に、どんな反射音がどれくらい続くかが、そのホールの音の個性になる。また反射音の後に続く響きが、聴こえなくなるまでの時間を「残響時間」といい、サントリーホールのようにオーケストラの演奏に向いた大きなホールでは2秒。その最初の0.1秒の反射音をどう設計するかで、そのホールの音のすべてが決まります。

直接音から0.1秒の間にどの方向からいくつ音がくるかで響きの印象が決定づけられるという。ホールの天井高や形、壁、天井、座席といった要素すべてで、バランスのいい響きを確保した音響設計をおこなっています。(永田音響設計事務所 小口恵司氏。)

・・・である。この世界懐かしすぎる。(笑)徹底的に解明したい神秘的なミステリアスであった。

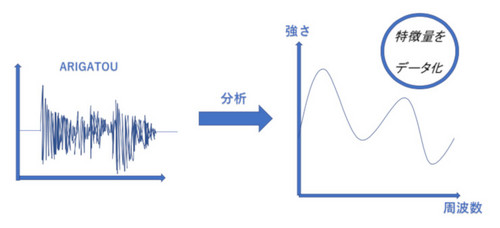

コンサートホールといえば、このホール音響なのである。AIを信号処理に使いたいとしたら、この音響のところに使えないか、というのは当然思いつく。AIの得意な処理として、解析というのがある。つまり入力データを学習させて、その特徴を形にするのである。

音響分析では、入力された音声データの音の強弱や周波数、音と音の間隔、時系列などさままな特徴量を抽出し、音響モデルで扱いやすい(コンピュータが認識しやすい)データに変換する。それをどんどん発展させていき、ホール音響の次元までにあげていく。

世界中のいろいろな国にあるコンサートホールの音響特性をAIで解析して、それを見える化できないか。そのホール固有の響きをAIで解析して、なにか形として残すのである。ホールによっていろいろな音響の形が測定されるであろう。

ただ、音響を解析するだけでは、ダメなのである。それじゃ実験に過ぎない。そこから我々のタメになることに応用したくなるのである。そこが最終形である。そのAIで解析した形から、音響補正できないか?自分はなにかできないか、ということを考えたとき、まず”補正”という言葉が思いついた。

音響補正である。

オーディオマニアならイコライザーとか、AVアンプの自動音場調整とか思い出しますね。それをひと回り大きく考えて、ホール音響そのものを補正できないか。

ホール音響は、もうそのホールを建ててしまったら、もう一義的に前述した条件下でホール音響、ホールの響きが決まってしまう。生憎条件が揃わなかったホールは、音響、響きが悪いホールとして烙印を押されてしまう。もうこの汚名はホールを解体するまで一生続くのである。

そのホールで音響をAI解析してその特徴を解析・見える化・データ化できたら、AIのデータの中には、音響の素晴らしいホールの音響の形という手本が蓄積されている。

そのお手本と比較して、その響きの悪いホール音響の形を、いい方向に補正していくのである。そうすると、どんなに響きの悪いホールでも、あら不思議、いい響きだわ、となってしまう。(笑)

デッドな響きで有名なイギリスのバービカン・ホールの中でAI解析をしてその音響の形を測定できたら、つぎに蓄積されているウィーン楽友教会の音響の形データを参考に補正をするのである。そうすると、あら不思議。バービカンホールの響きがまるでウィーン楽友教会のように豊潤で濃い響きに様変わり。。である。(笑)

この手法の欠点は、世界中どこのホールでも全部同じウィーン楽友教会の響きとなってしまうことである。(笑)

オーディオ製品では、部屋の固有の響きを自動で補正する機能が備わっている製品もある。部屋によって様々に変わる固有の響き、あるいはその欠点を補正して出力するのである。

オーディオの世界では、アンプ、スピーカーを通して出力するので、そういう部屋の響きの補正というのが実現可能である。

でもホール音響そのものを補正するとなると、やっぱり無理だろうか。(笑)アンプ、スピーカーが出力口ではなく、ホール全体の器で鳴っているものだから。

でもあきらめてはいけない。そんなことできっこないとバカにされていても、アイデアを出す側が偉いのである。ホール音響そのものを補正することは難しいかもだけれど、ホールの音響設計時にシュミレーションソフトで設計するとき、この音響AI解析という技術はプラグインで組み込まれているものではないのだろうか。

理想の音響の形にするために、どこをどう変えれば、その理想の音響の形に近づくのか、シュミレーション上で検討できるのである。手本に近づけるというアプローチであれば、どこそこの国のホールの響きと同じにしたい、というアプローチが可能になる。

ラトルがロンドンに新ホールを建設しようとしていたときに、ぜひミューザ川崎のような響きのホールにしたいと懇願した。そうすると、ミューザ川崎での音響をAI解析してその音響の形を測定する。そしてラトルのロンドン新ホール設計のシュミレーションのときは、その音響の形が、ミューザ川崎の音響の形のお手本に近づくように、ホール形状、材質、諸々のパラメータを変えていけばいいのではないだろうか。それはコンピュータシュミレーション上での検討段階では、簡単な操作のように思える。

現実問題、音響AI解析という技術は、現在存在するのである。

・音響AI解析による雨天時浸入水検知

・日立、音を解析するAIで製品や設備の異常音を検知

・AI音響解析サービス(下水道)に取り組む日本インフラ計測株式会社(産総研技術移転ベンチャー)

・音響診断AI化支援

コンサートホールの音響設計のときは、近い将来きっとそのシュミレーションソフトの中にAIはソフトプラグインとして組み込まれ、AIを使用しながら音響設計するという時代はそう遠からずそうなるに違いない。

でも自分は”DX時代のコンサートホール”というお題目で書いているので、ホール音響をAIでそのままリアル空間で変えてほしいのである。AIによる音響可変コントロールである。ホールによってはステージ上の反響板の高さを可変にすることで、演奏形態に応じて、その音響コントロールをしている。そんな音響可変コントロールをAIを使ってやってみたい。

どんなヘッポコホール音響設計でもあとで自在に音響修正できる。それをAIでできないか?そんなことを考えているのである。でもこんなことできるようになったら、ウィーン楽友教会のようなお手本になる音響をしたホールは、そんな計測、AI解析をさせたがらないですよね。(笑)みんなコピーされてしまうので。

ホール内でAIを使うケースとして、またもうひとつ候補がある。

それがレコーディングである。おそらくレコーディング、録音の世界では、もうすでにAI技術の導入は進んでいるに違いない。自分は最近全然ご無沙汰なので、まったくわからないがきっとそうに違いない。

AIを使ってこんなことができたらいいなーと思うのは、レコーディングのときの最終段のミックスダウンのとき。録音エンジニアの技量により、空間の取り方、音質の煌びやかさ、低音の強調度、帯域バランス感覚、エコーのかけ具合、バランスエンジニアの作業。。。ほんとうに様々な録音テイストの作品にできあがる。この世界もずいぶんご無沙汰しています。懐かしいです。いまやスマホで音楽聴いています。(笑)

これはレーベルによって、あるいは録音エンジニアによって、随分変わるテイストになるものなのである。これはレーベルの録音ポリシーと録音哲学なので、彼らはそこに誇りをもって働いている。

PENTATONEなら温度感の高いサウンド、BISならワンポイント録音の空間重視の録音、Channel Classicsなら前へ前へと出てくるようなエネルギー感の大きいサウンド。(しかし懐かしいな~。(笑))もうそれぞれで哲学があって、サウンドにオリジナリティがある。

このミックスダウン、編集時の最後の音作りの嗜好をAIに学習させることができないか。AIに学習させ、あとは、どのようなアーティストがどのような楽器、楽曲を演奏しても、それがオーケストラであったり、室内楽であったり、リサイタルであったり、そんなこといっさい構わず、AIに学習させた通りのサウンド作りの最終形が出来上がるのである。

きっとそのエンジニアであれば、そう調理したであろう、そういう録音テイストで仕上がっているのである、どんな演奏形態であっても。

エンジニア不要論である。(笑)

スンマセン、怒らないでください。ペーパー上の極論です。

ライナーノーツの録音部のクレジットのところは人の名前ではなく、AIと記載されているのである。

たぶんレコーディング、録音の世界では、マイキングでのステージ上でのマイク設定のポジショニングとか、ミックスダウンの編集時とか、絶対AIの利用はあるはずだと思っています。

コンサートホールでのAIの利用はこんなところにもあるのだな、と思いついた次第です。

2023-01-25 05:45

nice!(0)

コメント(0)

コメント 0